Machine Learning

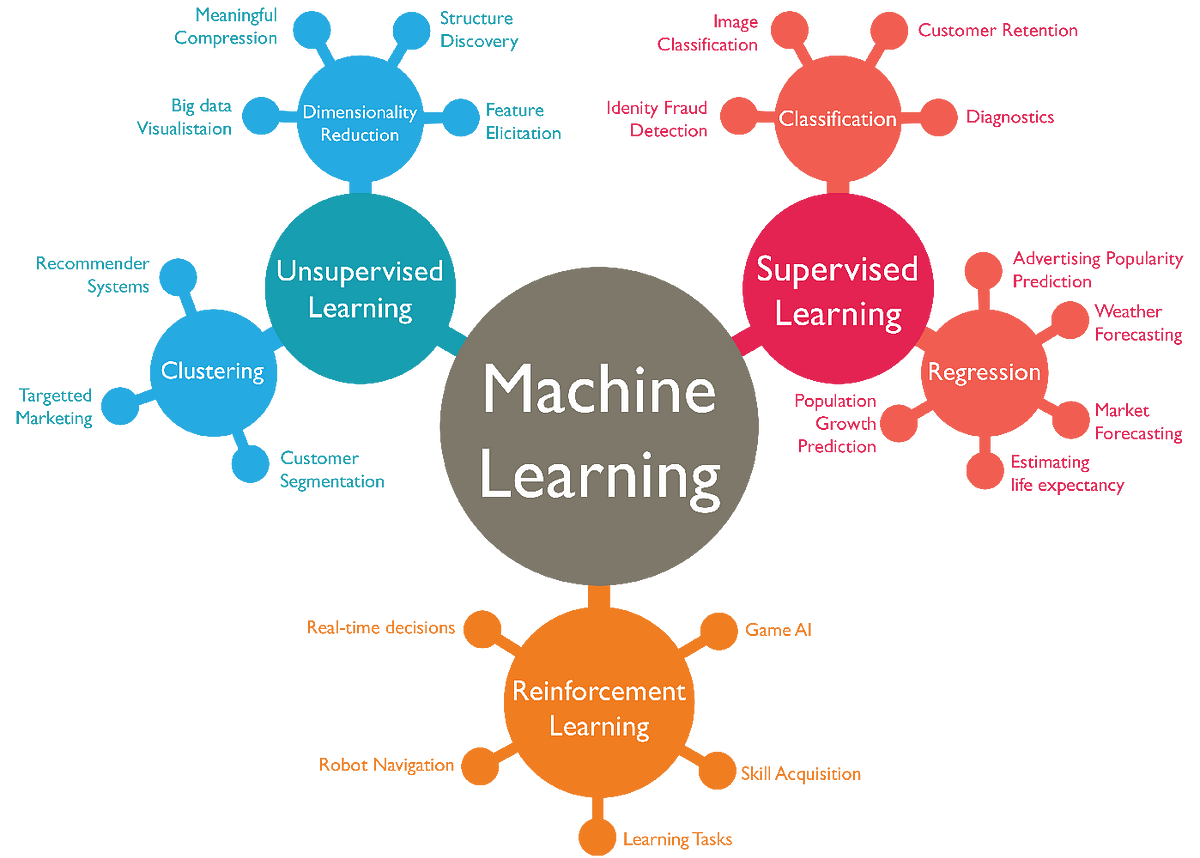

Supervised Learning(监督学习)

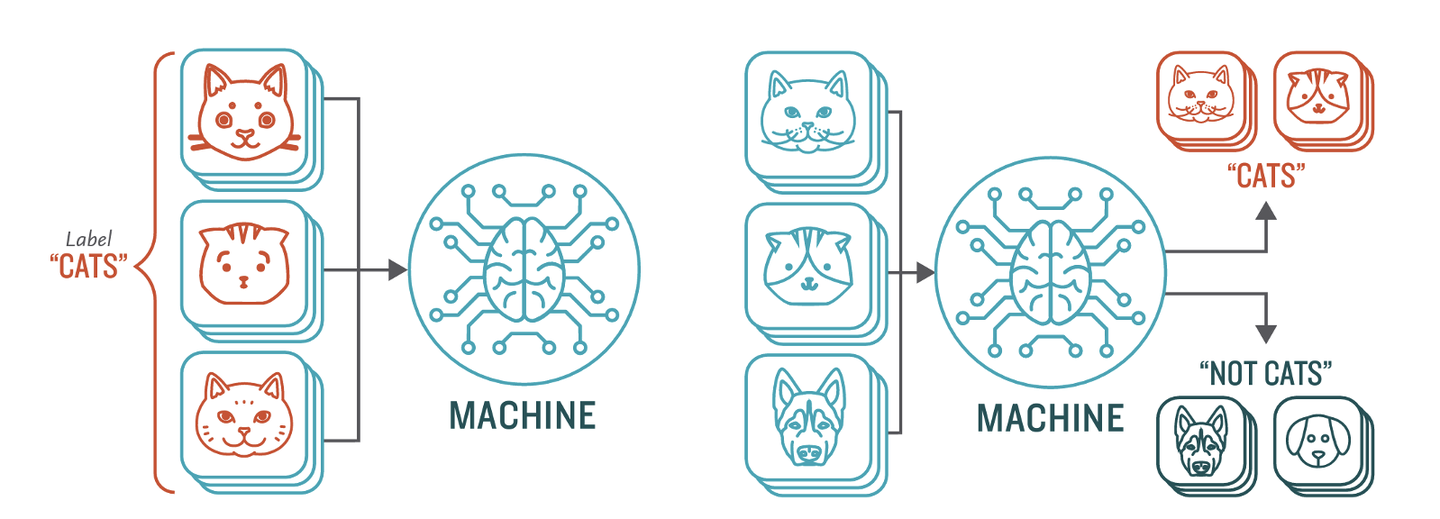

监督学习是机器学习和人工智能中的一种算法学习训练方式。它的定义是使用标记数据集来训练算法,以便训练后的算法可以对数据进行分类或准确预测结果。在监督学习中,每个样本数据都被正确地标记过。算法模型在训练过程中,被一系列 “监督”误差的程序、回馈、校正模型,以便达到在输入给模型为标记输入数据时,输出则十分接近标记的输出数据,即适当的拟合。

监督学习可以广泛应用于图像识别、自然语言处理、语音识别等领域。监督式学习可分为两类,分类和回归:

- 分类,Classification,使用一种算法来准确地将测试数据分配到特定的类别中,例如将垃圾邮件从你的收件箱中被识别出来并分类转移到一个单独的文件夹中。线性分类器、支持向量机、决策树和随机森林都是常用的分类算法。

- 回归,Regression,是另一种监督式学习方法,它使用一种算法来理解因变量和自变量之间的关系。回归模型有助于根据不同的数据点来预测数值,例如某一业务的销售收入预测。

Unsupervised Learning(无监督学习)

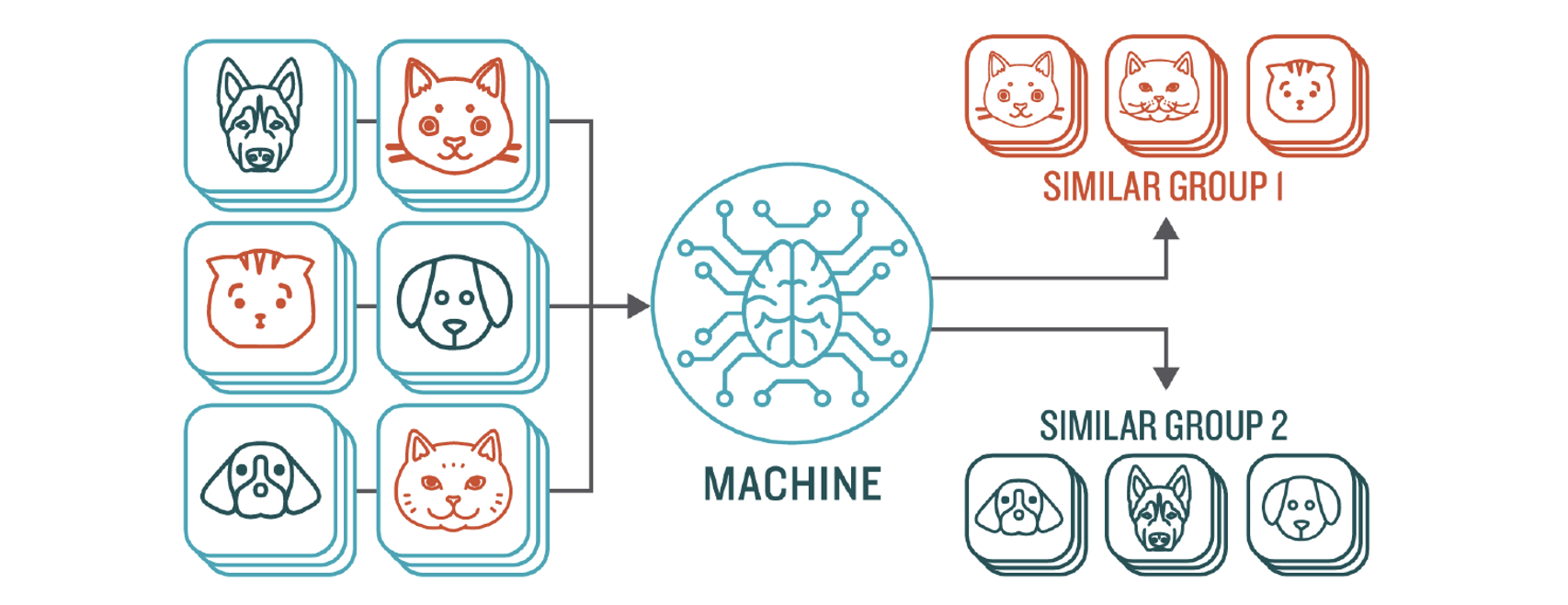

无监督学习用算法来分析并聚类未标记的数据集,以便发现数据中隐藏的模式和规律,而不需要人工干预。

无监督学习模型用于三个主要任务: 聚类、关联和降维:

- 聚类,Clustering,是一种数据挖掘技术,用于根据未标记数据的相似性或差异性对它们进行分类分组。这个技术适用于细分市场的划分、图像压缩等领域。

- 关联,Association,使用不同的规则来查找给定数据集中变量之间的关系。 这些方法经常用于“购物车”分析和推荐引擎,类似于“购买此商品的客户也购买了…”这种电商中的推荐算法。

- 降维,Dimensionality Reduction,当特定数据集中的特征(或维度)太多时,它在保持数据完整性的同时,将数据输入的数量(维度)减少到可管理可操作的大小。要知道有时候数据维度可能达到几千上万或更大的规模,这被称为“维度爆炸”。在这种情况下,我们首先要对数据维度进行筛选去除干扰的无重要意义的维度,即降维。因此,这种技术通常用于数据的预处理阶段,例如用自编码器把图片数据中的噪点去除,以提高图像质量。

其实无监督学习仍然需要人工干预来验证它的输出是否合理。比如数据分析人员需要验证电商推荐引擎将婴儿服装与尿不湿、苹果酱和吸管杯分组是否有实际意义。反过来,如果有一天,算法把两个我们人类看起来毫不相关的两种商品分类到一起,那我们或许会发现某种人类的潜在需求,我们需要认真对待这种分类,但这种潜在需求是否真的存在,我们尚且不知,仍需要市场去检验,但这至少启发了我们。

监督学习与无监督学习的本质区别就在于用来训练的数据是否已经被标注。这也导致了监督学习与无监督学习各有利弊。监督学习在处理大量数据的问题时比较吃力,但是一旦学习到位,其结果将非常准确和值得信赖。而无监督学习可以很轻松地同时处理大量的数据,可是是学习出来的结果不具备透明度,即无法解释。但也因此导致无监督学习可以发掘出许多以前未曾被人类注意的新规律。

监督学习与无监督学习各有各的优缺点,如何将两者的优点结合并规避缺点呢,于是半监督学习的模式诞生了。

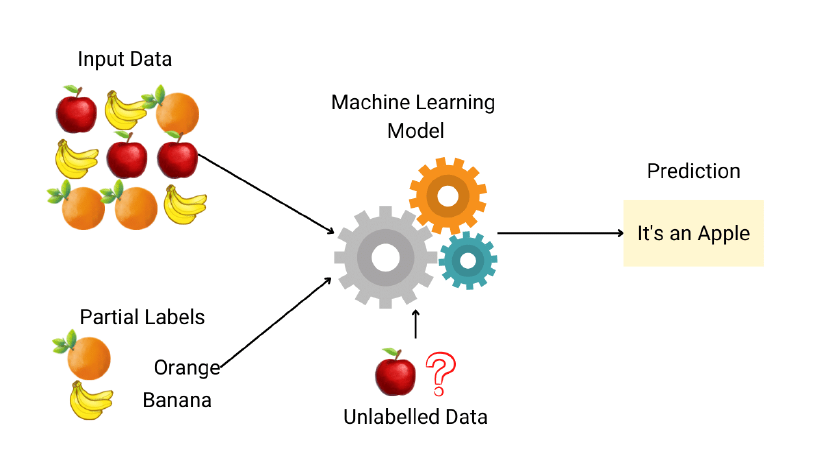

Semi-supervised Learning(半监督学习)

半监督学习或可称为混合学习(Hybrid Learning),可以说是两全其美的方式。在我们拥有相对较少的标记数据和大量未标记数据的情况下,半监督学习结合了监督学习和无监督学习的优势,于是在此时可以发挥很好的作用。要知道在海量数据面前,手动标记数据的成本过于高昂且繁琐,而未标记的数据很多、易于获取,且每日都会产生大量的数据。因此,我们可以只标记数据集中的一部分,而不是标记整个数据集,然后用半监督学习方式来学习。

Reinforcement Learning(强化学习)

强化学习是一种机器学习技术,它基于反馈的学习方法,对算法执行的正确和不正确行为分别进行奖励和惩罚的制度,目的是使算法获得最大的累积奖励,从而学会在特定环境下做出最佳决策。“强化”一词来自于心理学,心理学中的“强化”就是通过提供一种刺激手段来建立或者鼓励一种行为模式。这种“强化”模式很明显有两种:

- 积极强化ーー是指在预期行为呈现后,通过给予激励刺激以增加进一步导致积极反应。

- 负面强化,通过提供适当的刺激来减少出现负面(不希望的)反应的可能性,从而纠正不希望出现的行为。

想象一下,当你第一次玩马里奥,却没有人指导你怎么玩,你只能自己在游戏中探索环境和重要的 NPC,并随时做好心理准备面对行动的后果。一个错误的举动会导致失去一条“命”,一个正确的跳跃可以把我们带到一个更安全的地方并奖励金币!因此,伴随着奖励和惩罚的探索,牵动着你的大量尝试和错误 ,最终不断地优化你的行动,让你成为一个马里奥游戏的高手。这就是“强化”训练!

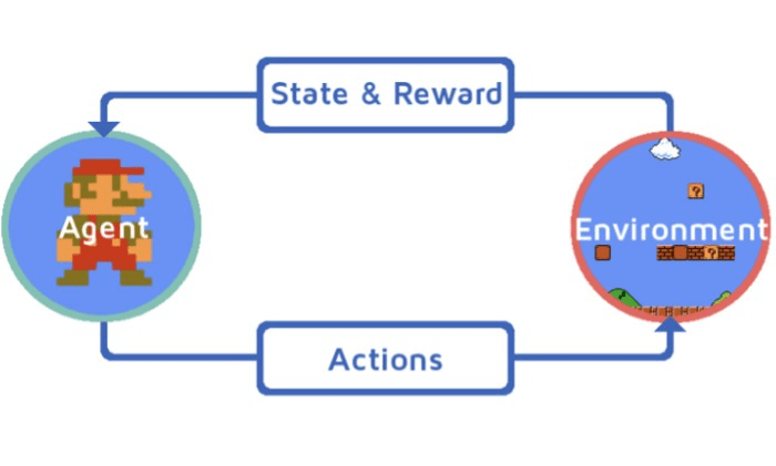

这里有几个“强化”学习的要素需要明确:

- 代理人,Agent:一个我们试图学习的实体(即玩家在游戏中所使用的角色)

- 环境,Environment:代理人所处的环境(游戏所设置的游戏世界设定)

- 状态,State:代理人在环境中获得自己当前状态的各种信息

- 行动,Actions:代理人在环境中所执行的与环境交互的各种动作(马里奥游戏中的行走、跑步、跳跃等等)

- 奖励,Reward:代理人从环境中获得的行动反馈(在马里奥的游戏里,即为正确的行动增加的积分/硬币,是一个积极的奖励。因落入陷阱或被怪物吃掉而丢失积分,或损失一条“命”,则是一个消极的奖励)

- 策略,Policy:根据代理人当前的状态决定一个合适的决策,以最大化地在未来某个时间段内获得正面报酬,最小化获得负面的惩罚

- 价值函数, Value function:决定什么才是对代理人是有益的

因此,强化学习完全可以被理解为一种游戏方式的学习机制。让机器算法学习做任务,做得好就有奖励做得不好就有惩罚。当然,奖励和惩罚机制本身也是一种算法,这些算法被先天性地植入到机器学习算法的最底层设计中,让其最本能地目标首要考虑就是如何去赢得奖励且规避惩罚。然后,给机器算法一个最终的目标即可!

Self-supervised Learning(自监督学习)

自监督学习不需要人工标注训练数据,它的模型主要训练从大规模的无监督数据中挖掘能够应用于自身的监督信息,从而从输入的一部分数据中去学习另一部分。

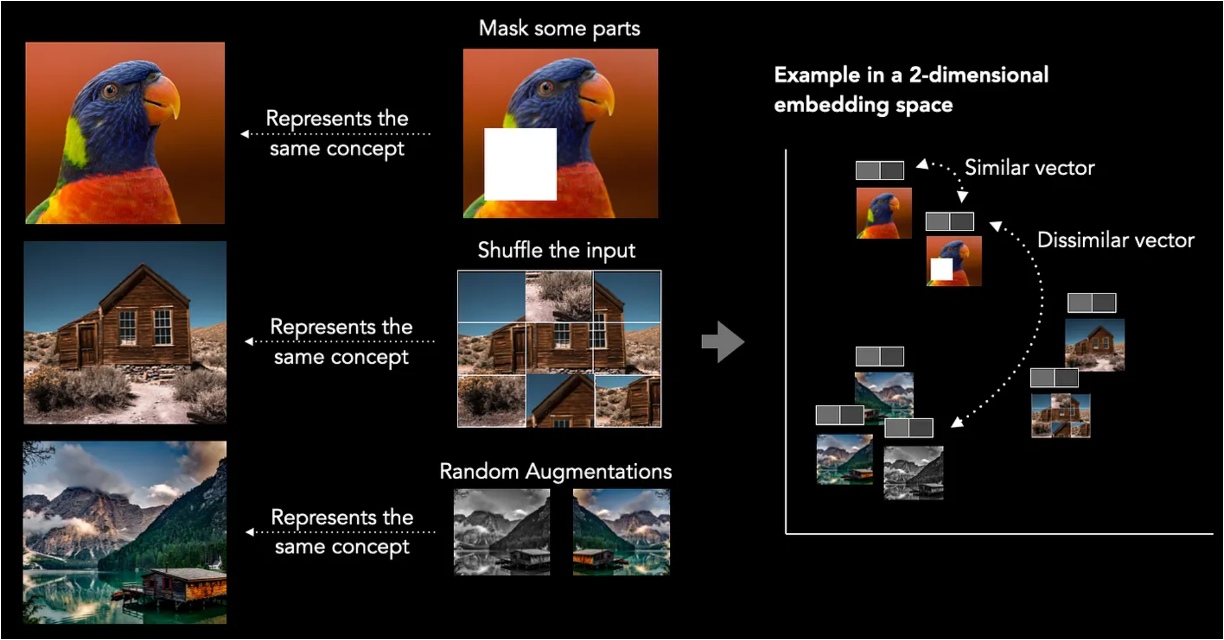

自监督学习可以通过对图片的剪裁、九宫格切割后再打乱、镜像或降低色彩饱和度等操作,让机器学会改变后的图像与原图像之间存在着十分接近的联系,这种紧密联系在二维的 Embedding 坐标空间中显示为极度靠近的坐标点。不仅仅是图片,自监督学习可以对音频、视频、文本进行同样的学习。然而这些紧密的联系,是无法通过人类标注员来操作的。就好比我们可以对图中的鸟标注为“鸟”,但是自监督学习只会把它标注为 Embedding 空间中数据结构位置信息,这在本质上和人类给这幅图标注为“鸟”是一个意思。

可以看出,自监督学习很容易被误解为无监督学习中的聚类,因为他们也同样是把不同的未标记的事物进行分类,但其实自监督学习是在最大化同一类样本在 Embedding 空间中表征的相似性,同时最小化不同类样本之间表征的相似性。要做到相同类别的事物表达相近,不同类别的事物表达要更远,也就是说要极端化这种对比。通过这样的极端化过程,编码器(Encoder)能学到样本在 Embedding 空间中的许多潜在特征。所谓物以类聚,人以群分!

所以,最终自监督学习将原始训练数据转化成了低维度 Embedding 空间中的某种特殊标记组合,这样的标记并不像直接标记成“鸟”这样的语言标记如此地清晰和单一,但却有着独特的优势。

比如对下图的标注,人类大多数会按照人类自己的语言认知标准去打标签,比如:马、草地、棕色、树林...等等。但实际上这幅图像上有更多更广阔的与马相关联的有价值的信息,比如:马站在草地上面而不是在草地下面、马的头部和尾部分别在身体的前后两端...等等等等,在数以千万计的马站在大自然环境中的照片进行集中机器学习时,甚至有很多我们人类绞尽脑汁也难以发觉得潜在隐藏规律都可以被机器挖掘出来。正因为这些种种的规律组合到一起,才使得所有马的信息在 Embedding 空间中集中在一起。

这样带来的好处显而易见,一来这样的隐藏规律的寻找对于人类来说是无法企及的,因为图像中的各种元素之间排列组合出的逻辑太多了,况且逻辑关系也过于隐蔽。二来,这有点像道德经上所讲的“道可道非常道,名可名非常名”的道理,一旦你给一个事物命名了,那么你就相当于给他标签化了,而一旦标签化,就很容易以偏概全,无法达到事物本来的真理层面。与其用某种语言的文字去打标签,不如直接用更印象派的方式去记录所有规律的总和。

大多数机器学习都需要海量的高质量标记数据,大量的高质量标记数据的成本在时间和金钱上的成本都非常高。比如,在图像领域的机器学习往往需要数百万个标记的大型数据集来学习,这样的标记则是通过大量人工来完成的。然而,将这些方法扩展到真正的互联网规模的数据集上(即数千亿张图像),则所需要的人工标注成本及时间将达到不可能实现的地步,这让所有研究机构都望而却步。自监督式学习则很好地帮助研究人员解决了大量的数据标记问题,虽然它并没有人工标注的清晰、确切,但却可以对巨量数据自动进行更广泛的标注,以对下游任务产生帮助。同时,自监督学习适合挖掘大量的数据集中不曾被人类关注过的“隐蔽”信息。训练数据集是任何大模型训练的核心资源,在数据为王的时代,自监督学习的优点使得人们充分相信它将是下一阶段人工智能发展的重点。

总结,每种学习方式都有其优缺点,需要根据具体任务选择最适合的学习方式。在实际应用中,可以将不同的学习方式进行组合,以提高模型的预测能力和泛化能力。